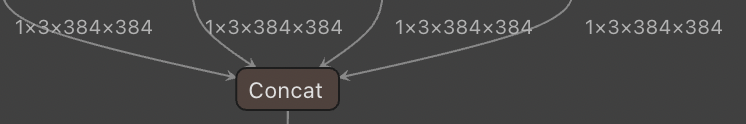

onnx2mge concat出现bug

为使您的问题得到快速解决,建议参考以下模板:

【标题】

(简洁、精准的描述您的问题,例如“int8模型,多次抽feature,存在可见误差”)

【版本、环境信息】

- MegEngine 版本:(请提供当前问题发生所使用的MegEngine 版本)

- CPU型号:(如为CPU,请提供CPU型号)

- GPU型号:(如为GPU,请提供GPU型号)

- 系统环境:(请提供系统环境,linux / windows / Android、手机型号等,包括是32位/64位)

- python版本: (请提供您使用的python版本号)

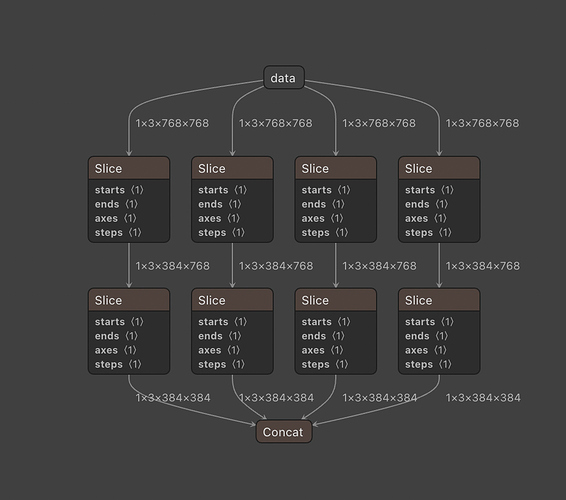

【模型信息】

- 算法:(请提供算法源码,如有特殊实现请简单介绍)

- 性能对比:(现在速度 vs 之前速度, shape是多少之类等)

- 模型文件地址:(请提供模型文件地址)

【Load_and_run LOG】

- 请提供Load_and_run复现LOG

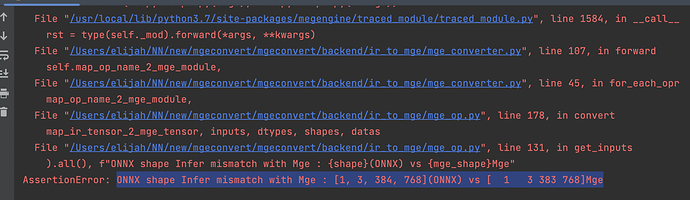

【如为报错请提供以下复现信息】

- 复现步骤:(请提供复现方法及步骤)

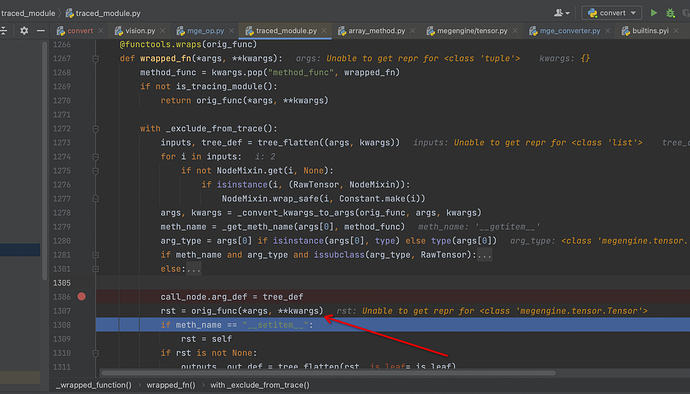

- 日志信息:(请提供完整的日志及报错信息)

- 代码关键片段:(请提供关键的代码片段便于追查问题)